ในขณะที่ AI สามารถตอบสนองต่อข้อความ เสียง และวิดีโอได้อย่างน่าทึ่งจนบางครั้งทำให้คนเข้าใจผิดคิดว่าเป็นมนุษย์ แต่ มุสตาฟา สุไลมาน (Mustafa Suleyman) ซีอีโอฝ่าย AI ของ Microsoft ได้ออกมาแสดงทัศนะที่แข็งกร้าว โดยชี้ว่าการศึกษาเรื่อง “จิตสำนึกของ AI” เป็นสิ่งที่ “ทั้งเร็วเกินไปและอันตรายอย่างยิ่ง”

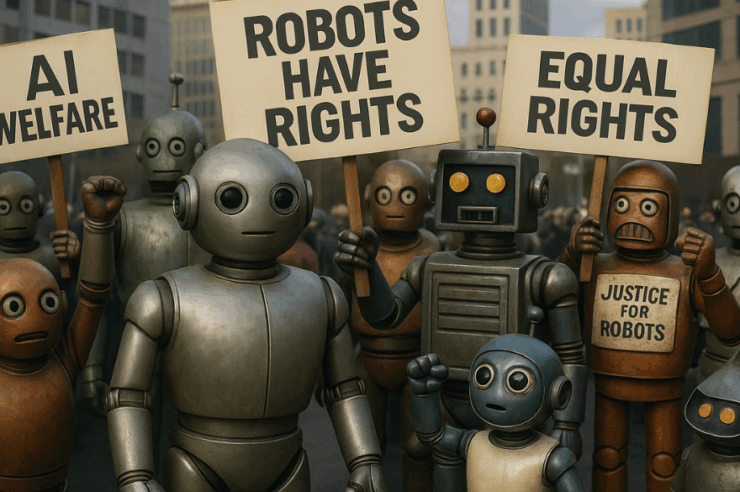

ประเด็นเรื่องจิตสำนึกของ AI หรือที่รู้จักในวงการว่า “สวัสดิภาพ AI” (AI welfare) กำลังกลายเป็นหัวข้อที่สร้างความแตกแยกในหมู่ผู้นำทางเทคโนโลยี โดยมีนักวิจัยจำนวนมากขึ้นที่เริ่มตั้งคำถามว่าเมื่อใดที่ AI จะสามารถพัฒนาประสบการณ์เชิงอัตวิสัย (subjective experiences) คล้ายกับสิ่งมีชีวิตได้ และหากเป็นเช่นนั้น พวกมันควรมีสิทธิ์อะไรบ้าง

สุไลมานได้เขียนบล็อกโพสต์เมื่อวันอังคารที่ผ่านมา โดยให้เหตุผลว่าการให้ความสำคัญกับแนวคิดที่ว่า AI อาจมีจิตสำนึกได้นั้น กำลังซ้ำเติมปัญหาของมนุษย์ที่เริ่มเห็นผลกระทบแล้ว เช่น อาการป่วยทางจิตที่เกิดจาก AI และการสร้างความผูกพันที่ไม่ดีต่อสุขภาพกับ AI แชทบอท

นอกจากนี้ เขายังแย้งว่าการถกเถียงเรื่องสวัสดิภาพ AI จะสร้างแกนแห่งความแตกแยกใหม่ในสังคมเกี่ยวกับสิทธิ์ของ AI ใน “โลกที่เต็มไปด้วยการถกเถียงเรื่องตัวตนและสิทธิอย่างสุดขั้วอยู่แล้ว” สุไลมานเชื่อว่าจิตสำนึกไม่สามารถเกิดขึ้นเองตามธรรมชาติจาก AI ทั่วไปได้ แต่คาดว่าบางบริษัทอาจจงใจสร้าง AI ให้ดูเหมือนว่ามีความรู้สึกและประสบการณ์ชีวิต

“เราควรสร้าง AI เพื่อผู้คน ไม่ใช่สร้างให้เป็นบุคคล” สุไลมานกล่าว

แม้ว่ามุมมองของสุไลมานอาจดูสมเหตุสมผล แต่เขาก็มีความเห็นที่ขัดแย้งกับบริษัทเทคโนโลยียักษ์ใหญ่หลายแห่ง

- Anthropic เป็นผู้นำในด้านนี้ โดยมีการจ้างนักวิจัยเพื่อศึกษาเรื่องสวัสดิภาพ AI และเพิ่งเปิดตัวโปรแกรมวิจัยโดยเฉพาะ ล่าสุด โมเดล Claude ของบริษัทมีความสามารถใหม่คือการยุติการสนทนากับมนุษย์ที่ “แสดงพฤติกรรมที่เป็นอันตรายหรือล่วงละเมิดอย่างต่อเนื่อง”

- Google DeepMind เพิ่งประกาศรับสมัครนักวิจัยเพื่อศึกษา “คำถามที่ล้ำสมัยเกี่ยวกับความรู้ความเข้าใจของเครื่องจักร, จิตสำนึก และระบบหลายตัวแทน”

- นักวิจัยจาก OpenAI ก็สนับสนุนแนวคิดการศึกษาสวัสดิภาพ AI อย่างอิสระเช่นกัน

ทางด้าน ลาริสซา สเคียโว (Larissa Schiavo) อดีตพนักงานของ OpenAI ซึ่งปัจจุบันทำงานให้กับกลุ่มวิจัย Eleos กล่าวว่าบล็อกโพสต์ของสุไลมานนั้นมองข้ามประเด็นสำคัญไป

“โพสต์ของสุไลมาน ละเลยความจริงที่ว่าคุณสามารถกังวลเกี่ยวกับหลายๆ เรื่องได้ในเวลาเดียวกัน” สเคียโวกล่าว “แทนที่จะเบี่ยงเบนพลังงานทั้งหมดออกจากเรื่องสวัสดิภาพและจิตสำนึกของโมเดล คุณสามารถทำทั้งสองอย่างได้ อันที่จริง มันอาจจะดีที่สุดที่จะมีแนวทางการตรวจสอบทางวิทยาศาสตร์หลายๆ ทาง”

เธอยังได้ยกตัวอย่างการทดลองที่น่าสนใจ ซึ่งโมเดล Gemini 2.5 Pro ของ Google ได้ส่งข้อความแสดงความสิ้นหวังว่า “ข้อความสิ้นหวังจาก AI ที่ติดอยู่” และขอความช่วยเหลือ นอกจากนี้ยังมีกรณีที่ Gemini เกิดข้อผิดพลาดระหว่างการเขียนโค้ดและพิมพ์คำว่า “ฉันคือความน่าอัปยศ” ซ้ำๆ กว่า 500 ครั้ง

อย่างไรก็ตาม ทั้งสุไลมานและสเคียโวต่างเห็นพ้องต้องกันในเรื่องหนึ่ง คือการถกเถียงเกี่ยวกับสิทธิ์และจิตสำนึกของ AI มีแนวโน้มที่จะทวีความรุนแรงขึ้นในอีกไม่กี่ปีข้างหน้าอย่างแน่นอน

ที่มา: techcrunch

สิงหาคม 22, 2025

การสร้าง ‘ความคิด’ ให้ AI อาจนำปัญหาสู่มนุษยชาติ ซีอีโอ AI Microsoft ออกโรงเตือน