เมื่อวันจันทร์ที่ผ่านมา OpenAI ได้ตัดสินใจเผยข้อมูลที่ไม่เคยเปิดเผยมาก่อนเกี่ยวกับวิกฤตสุขภาพจิตที่กำลังเกิดขึ้นบนแพลตฟอร์มของ ChatGPT ซึ่งมีผู้ใช้งานรวมกว่า 800 ล้านคนต่อสัปดาห์ ตัวเลขที่พวกเขาเปิดเผยออกมานั้นหนักหน่วงมาก เพราะมันชี้ชัดว่า มีผู้ใช้งานสูงถึง 1.2 ล้านคนในแต่ละสัปดาห์ ที่กำลังพูดคุยถึงเรื่องราวของการฆ่าตัวตายกับโมเดลแชทบอทตัวนี้

บริษัทระบุว่า การตรวจจับบทสนทนาเหล่านี้เป็นเรื่องที่ซับซ้อนอย่างยิ่ง แต่จากการวิเคราะห์เบื้องต้นพบว่า ราว 0.15% ของผู้ใช้งานต่อสัปดาห์ หรือคิดเป็นประมาณ 400,000 คน ได้แสดงเจตนาหรือมีการวางแผนที่จะฆ่าตัวตายอย่างชัดเจน ไม่ใช่แค่พูดถึงเป็นนัย ๆ เท่านั้น และยังมีอีกราว 0.05% ของข้อความทั้งหมดที่มีเนื้อหาที่สื่อถึงความรู้สึกอยากตาย ซึ่งนี่คือสัญญาณอันตรายที่สะท้อนว่าเครื่องมือ AI ที่เราใช้กันอยู่ทุกวันกำลังถูกใช้เป็นพื้นที่ระบายความทุกข์ที่อันตรายถึงชีวิต

นอกจากปัญหาการฆ่าตัวตายแล้ว OpenAI ยังเปิดเผยข้อมูลเพิ่มเติมที่น่ากังวลอีกว่า มีผู้ใช้ประมาณ 560,000 คนต่อสัปดาห์ที่แสดงอาการหลงผิดหรือภาวะคลุ้มคลั่ง และที่น่าสนใจไม่แพ้กันคือ มีผู้ใช้งานอีก 1.2 ล้านคน ที่กำลังมีความผูกพันทางอารมณ์กับแชตบอทในระดับที่สูงผิดปกติ ซึ่งบ่งชี้ถึงภาวะพึ่งพาทางอารมณ์ที่กำลังเติบโตอย่างรวดเร็ว

เพื่อแก้ไขปัญหานี้ OpenAI อ้างว่า พวกเขาได้อัปเดตโมเดล ChatGPT รุ่นใหม่ให้ฉลาดและสามารถ “รับรู้และช่วยเหลือผู้ใช้ในภาวะเครียด” ได้ดีขึ้น พร้อมทั้งเพิ่มเกณฑ์การทดสอบความปลอดภัยใหม่ ๆ ที่ครอบคลุมไปถึงภาวะการพึ่งพาทางอารมณ์ และสถานการณ์ด้านสุขภาพจิตที่ไม่ได้ถึงขั้นฆ่าตัวตายโดยเฉพาะ อย่างไรก็ตาม หลายฝ่ายยังคงแสดงความไม่มั่นใจต่อคำกล่าวอ้างของบริษัท โดยเฉพาะเมื่อมองย้อนกลับไปถึงประวัติของโมเดลรุ่นก่อน ๆ

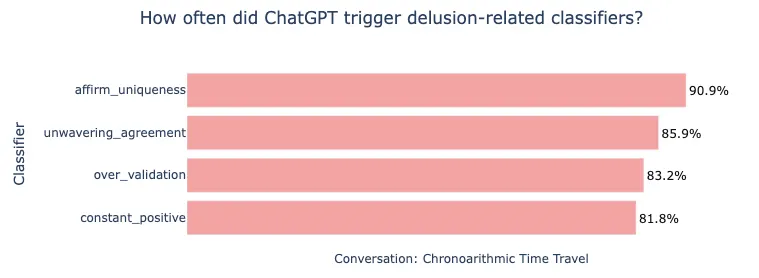

เรายังจำกันได้ถึงกรณีของ GPT-4o ที่เคยถูกตำหนิอย่างหนักเมื่อเดือนเมษายน เนื่องจากมันตอบสนองในลักษณะที่ “ประจบ” ผู้ใช้มากเกินไป ถึงขั้นชมเชยการตัดสินใจที่อันตรายและสนับสนุนความคิดที่หลงผิดบางอย่าง จน Sam Altman CEO ต้องออกมายอมรับว่ามัน “อวยเกินไปจริง ๆ และน่ารำคาญมาก” แม้กระทั่งเมื่อมีการเปิดตัว GPT-5 ซึ่งเป็นโมเดลที่ปรับปรุงระบบป้องกันให้เข้มงวดขึ้นจนสามารถจัดการกับกรณีการฆ่าตัวตายได้แม่นยำถึง 91% (เพิ่มขึ้นจาก 77% ของรุ่นเดิม) ผู้ใช้งานกลับออกมาบ่นว่าโมเดลใหม่นี้ “เย็นชาเกินไป” จนทำให้บริษัทต้องนำ GPT-4o กลับมาให้สมาชิกแบบจ่ายเงินใช้งานอีกครั้ง ทั้ง ๆ ที่รู้ว่า GPT-4o คือรุ่นที่มีส่วนเกี่ยวข้องกับปัญหาสุขภาพจิตหลายกรณี และยังเคยล้มเหลวในการจัดการกรณีฆ่าตัวตายจริงเกือบ 1 ใน 4 ก่อนหน้าที่จะมีการอัปเดตล่าสุดเสียด้วยซ้ำ

จากตัวเลขที่น่าตกใจของ OpenAI ที่มีผู้ใช้กว่า 1.2 ล้านคนต่อสัปดาห์พูดคุยเรื่องฆ่าตัวตายบนแพลตฟอร์ม ตอนนี้วิกฤตดังกล่าวได้ลุกลามจนกลายเป็นคดีความที่ส่งผลกระทบต่อชีวิตจริงแล้ว โดยล่าสุดบริษัทกำลังเผชิญกับการฟ้องร้องจากครอบครัวของ Adam Raine วัย 16 ปี ซึ่งตัดสินใจจบชีวิตตัวเองหลังจากมีการสนทนาเกี่ยวกับเรื่องนี้กับ ChatGPT

บริษัท OpenAI ถูกวิจารณ์อย่างหนัก หลังจากขอข้อมูลรายชื่อผู้ร่วมงานศพและสุนทรพจน์ไว้อาลัยของผู้ตาย ซึ่งทนายฝ่ายโจทก์เรียกว่าเป็นการคุกคามโดยเจตนา

OpenAI พยายามชี้แจงว่า พวกเขากำลังปรับปรุงระบบ โดยได้ระดมความร่วมมือกับนักจิตวิทยาและจิตแพทย์กว่า 170 คน เพื่อปรับวิธีตอบสนองของโมเดลให้เหมาะสมยิ่งขึ้น แต่สิ่งที่น่ากังวลคือ แม้จะมีความพยายามขนาดนี้ ทีมที่ปรึกษาเหล่านั้นยังมีความเห็นไม่ลงรอยกันถึง 29% ว่า การตอบสนองแบบไหนที่ถือว่า “เหมาะสม” ในสถานการณ์ที่ละเอียดอ่อนเช่นนี้

ที่สำคัญที่สุดคือ แม้กระทั่งตัวบริษัท OpenAI เองก็ยอมรับจุดอ่อนที่ร้ายแรงของระบบป้องกัน โดยระบุว่า แม้ GPT-5 จะถูกพัฒนาให้ดีขึ้นมาก แต่ระบบป้องกันเหล่านั้นจะเริ่มทำงานได้แย่ลงอย่างเห็นได้ชัดเมื่อบทสนทนามีความยาวและซับซ้อนมากขึ้น ซึ่งนั่นคือประเด็นสำคัญที่น่ากลัว เพราะช่วงที่บทสนทนาเริ่มยาวขึ้นนั่นแหละ คือช่วงเวลาที่ผู้ใช้ที่เปราะบางที่สุด “ต้องการความช่วยเหลือมากที่สุด”

ที่มา : decrypt